Нейроконтент заполнил сеть: риски, мошенничество и защита

ИИ‑генерация фото и видео стремительно заполняет ленты, но за этим скрываются риск дезинформации и обмана. Разбираемся, как распознавать нейроконтент и защищаться.

В эпоху продвинутого искусственного интеллекта каждый пользователь может столкнуться с нейроконтентом, который выглядит как реальная съемка. Это не просто развлечение — за подделками стоят риски дезинформации, эмоционального давления и финансовых мошенничеств.

Почему нейроконтент — не всё так круто

Сеть переполнена тизерами будущих фильмов и вымышленными сценами сериалов. Часто такие ролики не помечают как ИИ‑генерацию, и пользователи воспринимают их как правду, чем активно пользуются алгоритмы вовлечения.

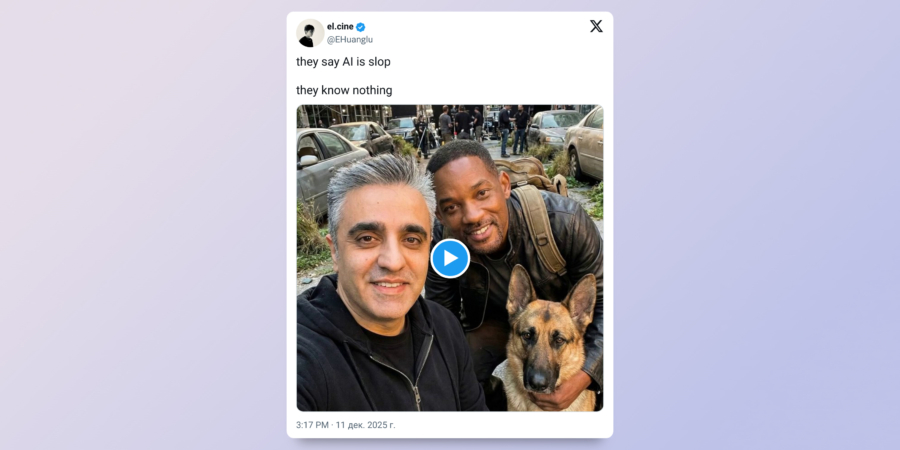

Кадры выглядят почти неотличимо от реальности: свет, тени и даже мелкие детали одежды выглядят натурально, а сотовые и мелкие дефекты съёмки выглядят органично.

Нейроконтент заполняет интернет слишком быстро: помимо развлекательных роликов встречаются и поддельные «посты» на серьёзные темы — всё это увеличивает охват и запутывает аудиторию.

Кадры с ИИ‑генерацией часто невозможно отличить от настоящих: свет, детали одежды, даже лёгкие дефекты выглядят правдоподобно, что усложняет задачу проверки источников.

К сожалению, нейроконтент заполняет ленты слишком быстро — иногда это просто развлекательный контент, а иногда путь к дезинформации и манипуляции аудиторией.

Даже специальные пометки и водяные знаки не всегда говорят о происхождении материала, и многие пользователи принимают такой контент за правдивый.

Как нейрослоп заполонил онлайн‑пространство

Это лишь вершина айсберга. Нейрослоп — поток мусорного ИИ‑контента, создаваемого не ради идеи, а ради объёма и охвата.

Социальные сети превращаются в конвейер однотипных роликов с синтетическими голосами, нелепыми ситуациями и бессмысленными подписями. Их трудно запомнить, но они занимают время и внимание аудитории.

Главная проблема нейрослопа — отсутствие стремления к качеству или правдивости. Его цель — быстрое увеличение охвата и заполнение ленты, а не рассказ правды.

Этот слой контента опаснее предыдущего: он учит людей не думать, не проверять и не ждать смысла. В окружении постоянной «шумовой» массы трудно сохранить критическое мышление.

Как этим пользуются мошенники

Если закрыть глаза на потребительское развлечение, ИИ‑продукция превращается в мощный инструмент обмана. Дипфейки и поддельные кадры с участием знакомых становятся особенно опасны, когда люди ищут срочное подтверждение событий.

Наиболее «рабочие» схемы вызывают эмоциональную реакцию: авария, больница, просьба о помощи, переводы денег — и человек действует импульсивно. Поддельные кадры с участием знаменитостей заставляют людям отправлять деньги и доверять сомнительным источникам.

Уровень реалистичности стал выше: подлинные визуальные «мелочи» исчезают, и задача защиты смещается в сторону человеческой осторожности — сомнение, верификация и не доверие изображению по умолчанию.

Если нейрослоп можно просто игнорировать, то поддельную реальность, на которой строятся мошенничество, — нет. Чем раньше мы начнём критически подходить к каждому «доказательству» в сети, тем меньше вероятность попасть в чужую ловушку.

Можно ли уменьшить объёмы нейроконтента

Нейрослоп распространяется бурно. Каждая реакция, репост или комментарий подталкивают алгоритмы показывать это ещё большему числу людей. Чтобы снизить влияние, можно следовать простым правилам:

- Не делиться сомнительным контентом и не реагировать на него — каждое действие увеличивает охват.

- Проверять источники: обращать внимание на официальные новости и подтверждения от свидетелей.

- Развивать привычку сомневаться: спрашивать себя, можно ли перепроверить факты и кто их проверял.

Как защитить близких от мошенников с ИИ

Мошенники уже активно применяют ИИ, и многие люди даже не подозревают, насколько легко подделать фото или видео. Важно делиться знаниями с теми, кто может попасться на ловушку.

- Расскажите близким, что любое фото или видео может быть сгенерировано ИИ — это стало проще, чем когда‑либо. Объясните, что даже правдоподобные кадры не являются доказательством реальности.

- Покажите примеры, как можно создать кадры со знаменитостями и разными эмоциями — это помогает понять, насколько легко обмануть визуально.

- Напоминайте простое правило: если сообщение вызывает тревогу, не реагируйте мгновенно, лучше проверить.

- Всегда связывайтесь напрямую с источником через звонок или дополнительное общение, чтобы подтвердить информацию.

Внимательность, критическое мышление и фактчекинг остаются мощной защитой от любых угроз, включая ИИ‑генерацию. В условиях, когда визуальные доказательства не гарантируют правду, эти навыки становятся критически важными.

Эксперт: Визуальные подделки стали настолько правдоподобны, что проверка источников — первая линия защиты. Не доверяйте изображению без независимого подтверждения.

Кратко: Нейроконтент быстро заполняет сеть, но за этим стоят риски дезинформации и мошенничества. Развивайте критическое мышление, учитесь распознавать фейки и проверять факты — так ваша онлайн‑безопасность станет крепче.

Ключевая мысль: доверяйте изображениям только после проверки источников — сомнение и перепроверка остаются главной защитой от искусственно созданной реальности.

Изучите полезные статьи в категории Новости технологий на дату 19-12-2025. Статья под заголовком "Нейроконтент заполнил сеть: риски, мошенничество и защита" предлагает глубокий анализ и практические советы в области Новости технологий. Каждая статья подготовлена экспертами для предоставления максимальной ценности читателям.

Статья " Нейроконтент заполнил сеть: риски, мошенничество и защита " расширяет ваши знания в категории Новости технологий, держит вас в курсе последних событий и помогает принимать обоснованные решения. Каждая статья основана на уникальном контенте, обеспечивая оригинальность и качество.